views

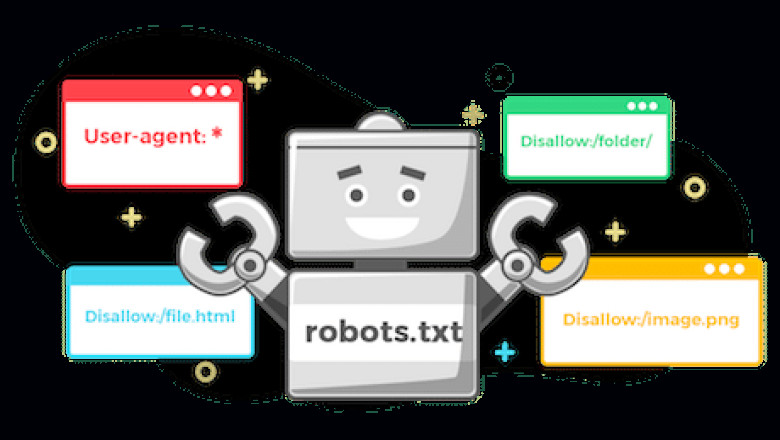

Apa Itu Robots.txt?

File robots.txt adalah sebuah file teks yang terletak di direktori utama situs web dan berfungsi untuk memberi tahu robot mesin pencari (seperti Googlebot) bagian mana dari situs yang boleh dan tidak boleh mereka akses. Dengan kata lain, robots.txt berfungsi sebagai pengatur lalu lintas crawler yang mengindeks situs web.

Sebagai contoh, jika Anda ingin mencegah mesin pencari mengindeks halaman tertentu dari situs Anda, Anda dapat mengonfigurasi file robots.txt untuk memblokirnya. Ini dapat membantu Anda mengelola bagaimana situs Anda ditangani oleh mesin pencari dan mengontrol konten yang akan ditampilkan di hasil pencarian.

Format Robots.txt

Sebuah file robots.txt biasanya memiliki sintaks sederhana, seperti:

Penjelasan dari aturan ini:

-

User-agent menunjukkan robot mesin pencari tertentu yang akan dipengaruhi aturan ini.

-

Disallow menunjukkan folder atau halaman yang tidak boleh diakses oleh robot.

-

Allow menunjukkan folder atau halaman yang diizinkan diakses oleh robot, meskipun ada aturan

Disallowyang lebih umum.

Mengapa Robots.txt Penting?

-

Mengatur Akses Crawler

Robots.txt membantu mengatur crawler mesin pencari agar mereka tidak mengindeks halaman yang tidak relevan atau tidak diinginkan, seperti halaman admin, halaman login, atau halaman yang sedang dalam pengembangan. Ini tidak hanya membantu menghindari duplikasi konten, tetapi juga dapat mencegah halaman yang tidak diinginkan muncul di hasil pencarian. -

Meningkatkan Kinerja Situs

Dengan membatasi crawler dari mengakses halaman yang tidak penting, Anda mengurangi beban server dan meningkatkan kecepatan pengindeksan halaman yang relevan. Hal ini sangat membantu terutama pada situs besar dengan banyak halaman. -

Keamanan dan Privasi

Robots.txt juga digunakan untuk membatasi crawler mengakses halaman sensitif atau pribadi yang seharusnya tidak terindeks oleh mesin pencari. Meskipun ini bukan metode keamanan yang kuat, ini bisa menjadi lapisan tambahan untuk melindungi informasi sensitif. -

Mengontrol Budget Crawl

Googlebot dan crawler lainnya memiliki "crawl budget" atau kuota pengindeksan untuk setiap situs web. Dengan menggunakan robots.txt untuk memblokir akses ke halaman-halaman yang tidak penting, Anda dapat memastikan crawler fokus pada halaman yang lebih penting dan relevan.

Masalah Umum dengan Robots.txt

Meskipun robots.txt adalah alat yang sangat berguna, beberapa masalah bisa muncul saat mengonfigurasi atau menggunakannya. Berikut adalah beberapa masalah umum yang sering terjadi:

1. Menggunakan Robots.txt untuk Mengamankan Halaman Sensitif

Masalah:

Banyak pemilik situs yang percaya bahwa dengan memblokir akses mesin pencari ke halaman sensitif menggunakan robots.txt, mereka dapat melindungi informasi tersebut dari pengindeksan. Namun, ini bukan solusi keamanan yang baik. Meskipun mesin pencari diinstruksikan untuk tidak mengakses halaman tertentu, file robots.txt adalah file publik yang dapat diakses oleh siapa saja, termasuk hacker.

Solusi:

Untuk melindungi halaman sensitif, gunakan otentikasi atau sistem login untuk membatasi akses, atau pertimbangkan menggunakan noindex dalam meta tag HTML daripada mengandalkan robots.txt.

2. Menghapus Halaman yang Terlalu Banyak

Masalah:

Salah satu masalah yang sering ditemui adalah terlalu banyak menggunakan aturan Disallow pada file robots.txt. Terlalu banyak membatasi halaman bisa menyebabkan konten penting tidak terindeks oleh mesin pencari, sehingga mengurangi visibilitas situs di hasil pencarian.

Solusi:

Hanya blokir halaman yang benar-benar tidak relevan untuk pengindeksan. Misalnya, halaman duplikat atau halaman login. Pastikan Anda tidak menghalangi halaman yang seharusnya diindeks oleh mesin pencari.

3. Menggunakan Robots.txt untuk Menghindari Duplikasi Konten

Masalah:

Beberapa pemilik situs berusaha menghindari duplikasi konten dengan menggunakan robots.txt untuk memblokir bagian tertentu dari situs. Ini bisa mengakibatkan halaman yang lebih penting tidak terindeks dengan benar.

Solusi:

Daripada menggunakan robots.txt untuk mengatasi duplikasi konten, gunakan tag canonical atau pengaturan noindex pada halaman yang terduplikasi. Ini lebih efektif dalam memberi tahu mesin pencari halaman mana yang harus diutamakan.

4. Tidak Memahami Sintaksis Robots.txt yang Salah

Masalah:

Kesalahan sintaksis pada file robots.txt bisa menyebabkan pengaturan yang salah, seperti memblokir halaman penting atau memberikan izin untuk halaman yang seharusnya dibatasi. Contoh kesalahan adalah lupa menambahkan garis pemisah antara User-agent dan aturan lainnya atau menempatkan file robots.txt di lokasi yang salah.

Solusi:

Pastikan file robots.txt diletakkan di direktori utama situs dan cek kembali sintaksisnya. Anda bisa menggunakan alat pengecek robots.txt yang disediakan oleh Google untuk memastikan file Anda benar.

5. Mengizinkan Akses pada Semua Konten

Masalah:

Mengizinkan semua crawler untuk mengakses situs Anda dengan aturan seperti User-agent: * Allow: / tanpa pembatasan bisa mengakibatkan halaman yang tidak relevan atau sensitif terindeks oleh mesin pencari.

Solusi:

Berikan batasan yang jelas mengenai bagian mana yang boleh diakses oleh crawler dan pastikan Anda tidak membuka akses pada data yang seharusnya tetap tertutup.

Solusi dan Praktik Terbaik untuk Mengelola Robots.txt

-

Gunakan Robots.txt dengan Bijak

Batasi akses ke halaman atau folder yang tidak relevan, seperti folder admin atau halaman login. Jangan gunakan robots.txt untuk menghindari masalah duplikasi konten. -

Periksa Robots.txt Secara Berkala

Lakukan audit berkala untuk memastikan file robots.txt Anda tidak menghalangi halaman yang seharusnya diindeks oleh mesin pencari. -

Gunakan Meta Tags atau Canonical Tags untuk Menghindari Duplikasi

Alihkan perhatian mesin pencari dari halaman yang terduplikasi dengan menggunakan tag noindex atau tag rel="canonical" di HTML, bukan hanya mengandalkan robots.txt. -

Mengoptimalkan Crawl Budget

Gunakan robots.txt untuk mengarahkan crawler ke halaman yang lebih penting dan relevan, memastikan crawl budget digunakan secara efisien. -

Tes dan Validasi Robots.txt

Gunakan alat Google Search Console untuk memeriksa dan memvalidasi file robots.txt Anda, serta untuk mengetahui apakah ada masalah pengindeksan yang disebabkan oleh file ini.

Kesimpulan

File robots.txt adalah alat yang sangat penting dalam pengelolaan dan pengindeksan situs web oleh mesin pencari. Dengan menggunakan robots.txt dengan benar, Anda dapat mengontrol bagaimana dan kapan crawler mengakses halaman tertentu dari situs Anda. Namun, masalah umum seperti membatasi akses yang berlebihan, kesalahan sintaksis, dan mencoba mengamankan halaman sensitif dengan cara yang salah dapat menyebabkan masalah dalam pengindeksan dan visibilitas situs Anda.

Dengan mengikuti praktik terbaik dan memeriksa file robots.txt secara teratur, Anda dapat memastikan bahwa situs Anda dioptimalkan untuk SEO dan dapat diakses oleh mesin pencari secara efisien tanpa mengorbankan konten penting.

Berikut adalah beberapa contoh file robots.txt yang mengatasi berbagai masalah umum dalam pengelolaan akses crawler atau robot mesin pencari.

1. Menutup Semua Akses ke Situs untuk Semua Crawlers

Jika Anda ingin mencegah semua mesin pencari mengakses situs Anda, Anda bisa menggunakan file robots.txt berikut:

Penjelasan:

-

User-agent: *berarti aturan ini berlaku untuk semua crawler. -

Disallow: /berarti tidak ada halaman yang diizinkan untuk diakses, bahkan halaman utama atau root dari situs.

2. Memblokir Crawlers dari Mengakses Folder atau Halaman Tertentu

Misalnya, jika Anda ingin memblokir semua crawlers mengakses folder private atau halaman tertentu seperti admin.html:

Penjelasan:

-

Disallow: /private/akan mencegah crawler mengakses seluruh folderprivate. -

Disallow: /admin.htmlakan memblokir akses ke halaman admin tertentu.

3. Mengizinkan Semua Crawlers untuk Mengakses Situs Kecuali Beberapa Halaman Tertentu

Jika Anda ingin agar semua mesin pencari dapat mengakses situs Anda, tetapi memblokir beberapa halaman atau folder tertentu (misalnya, halaman login atau halaman khusus), Anda bisa menggunakan konfigurasi berikut:

Penjelasan:

-

Disallow: /login/mencegah crawler mengakses halaman login. -

Disallow: /user-data/mencegah akses ke folder yang berisi data sensitif pengguna.

4. Mengizinkan Crawler Tertentu Saja untuk Mengakses Bagian Situs

Jika Anda ingin memberikan akses hanya kepada crawler tertentu (misalnya, Googlebot), Anda bisa menyesuaikan file robots.txt sebagai berikut:

Penjelasan:

-

User-agent: Googlebotberarti aturan ini hanya berlaku untuk Googlebot (crawler Google). -

Disallow: /private/mencegah Googlebot mengakses folderprivate. -

Allow: /public/memungkinkan Googlebot mengakses folderpublic, meskipun ada pengaturanDisallowyang lebih umum.

5. Memblokir Semua Crawler dari Mengakses Halaman Dinamis dengan Parameter URL

Beberapa halaman di situs Anda mungkin menggunakan URL dinamis dengan parameter (misalnya, page.php?id=123), dan Anda ingin mencegah crawler mengindeks halaman-halaman ini untuk menghindari duplikasi konten. Berikut adalah contoh pengaturan robots.txt untuk ini:

Penjelasan:

-

Disallow: /*?id=mencegah crawler mengakses halaman yang URL-nya mengandung parameterid, yang sering digunakan untuk halaman dinamis.

6. Mengizinkan Crawler Mengakses Halaman Tertentu Meski Ada Pembatasan

Kadang-kadang, Anda ingin membatasi akses ke sebagian besar situs tetapi mengizinkan akses ke halaman tertentu, misalnya halaman berisi informasi penting seperti sitemap atau halaman produk. Berikut contoh file robots.txt untuk situasi tersebut:

Penjelasan:

-

Disallow: /mencegah semua crawler mengakses halaman apapun dari situs Anda. -

Allow: /sitemap.xmlmengizinkan akses ke file sitemap, yang penting untuk membantu mesin pencari mengindeks situs Anda dengan benar. -

Allow: /product-page/mengizinkan akses ke halaman produk tertentu meskipun sebagian besar situs dibatasi.

7. Menyaring Crawler Tertentu

Jika Anda ingin mencegah crawler tertentu mengakses situs Anda, Anda bisa menambahkan aturan yang memblokir akses untuk user-agent tertentu (misalnya, BadBot).

Penjelasan:

-

User-agent: BadBotberarti aturan ini hanya berlaku untuk crawler dengan namaBadBot. -

Disallow: /mencegahBadBotmengakses seluruh situs.

8. Mengizinkan Semua Crawlers untuk Mengakses Semua Halaman

Jika Anda ingin memberikan akses penuh kepada semua mesin pencari dan mengizinkan mereka untuk mengindeks seluruh situs Anda, gunakan file robots.txt yang sangat sederhana:

Penjelasan:

-

User-agent: *berarti aturan ini berlaku untuk semua crawler. -

Disallow:tanpa path berarti tidak ada halaman yang diblokir, dan semua halaman di situs dapat diakses.

9. Menggunakan Robots.txt untuk Menghindari Pengindeksan Gambar atau File Media

Jika Anda tidak ingin gambar atau file media tertentu terindeks oleh mesin pencari, Anda bisa menggunakan robots.txt untuk memblokir akses ke folder gambar atau media:

Penjelasan:

-

Disallow: /images/mencegah crawler mengakses folder gambar. -

Disallow: /videos/mencegah akses ke folder yang berisi video atau file media lainnya.

Kesimpulan

File robots.txt adalah alat yang sangat berguna dalam mengelola akses crawler mesin pencari ke situs Anda. Dengan menggunakan file robots.txt dengan bijak, Anda dapat mengoptimalkan pengindeksan situs Anda, menghindari masalah duplikasi konten, serta melindungi halaman sensitif dari pengindeksan. Penting untuk memeriksa file robots.txt secara teratur dan memastikan aturan yang ada tidak membatasi akses ke halaman penting yang perlu terindeks.

Jika Anda tidak yakin tentang pengaturan yang tepat untuk situs Anda, pastikan untuk melakukan uji coba dan menggunakan alat seperti Google Search Console untuk memverifikasi bahwa robots.txt Anda tidak menghalangi halaman penting.

Comments

0 comment